Salut les Inphinautes !

Quand on pense quantique, des noms nous viennent assez naturellement à l’esprit pour peu qu’on s’y intéresse un peu : Planck, Bohr, Schrödinger, Heisenberg, Feynman ou même Einstein… Mais on pense rarement à Louis de Broglie. Pourtant, son apport à la mécanique quantique naissante, nous allons le voir, est considérable ! Tellement considérable qu’il a reçu un Nobel en 1929.

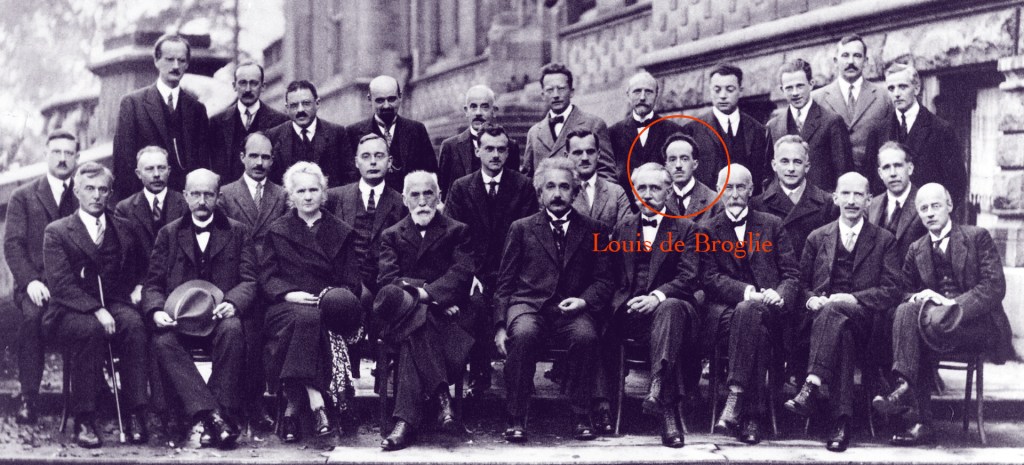

Alors pourquoi est-il oublié de la sorte… Principalement parce que son interprétation de la mécanique quantique s’opposait à l’interprétation orthodoxe et majoritairement admise, celle qu’on appelle l’interprétation de Copenhague, ville d’origine de Niels Bohr, qui n’est d’ailleurs pas étrangère à la mise au ban du physicien français pendant le congrès Solvay de 1927.

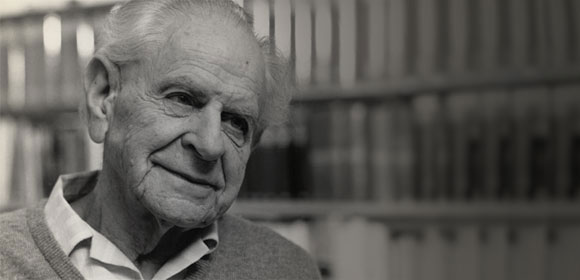

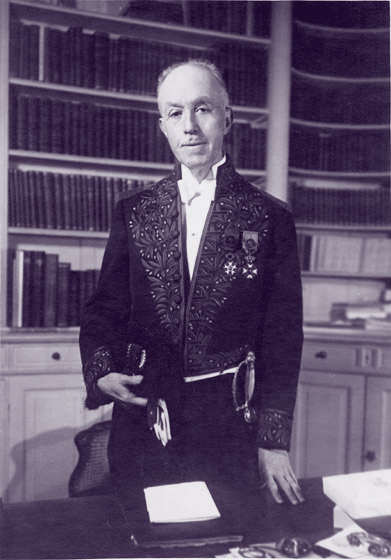

Le Prince de Broglie

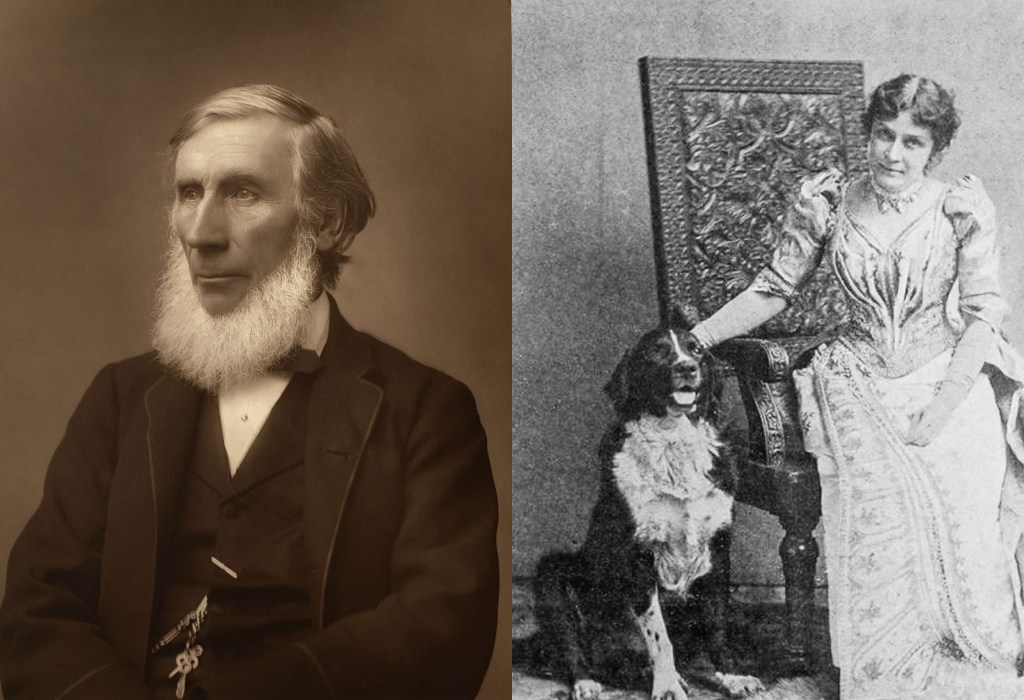

Louis Victor Pierre Raymond de Broglie naît le 15 août 1892 à Dieppe, au sein d’une grande famille de l’aristocratie française. Son père est le duc Victor de Broglie, titre qui lui reviendra à la mort de son grand frère Maurice. Il grandit donc dans l’hôtel particulier familial, dans un milieu très lettré, entouré d’art et de livres… et à vrai dire, rien ne le prédestinait cependant à devenir un grand physicien.

C’est d’ailleurs son frère Maurice qui va mettre Louis, de 17 ans son cadet, sur la voie de la physique, alors qu’il se dirigeait vers d’autres études.

De l’historien au physicien

En effet, Louis, suivant la tradition familiale, se dirige initialement vers les sciences humaines. Il est licencié d’histoire en 1910 à la Sorbonne. Il gardera de cet enseignement un esprit conceptuel et presque philosophique, plus enclin aux vues d’ensemble qu’à la pensée analytique et aux calculs théoriques.

« Pour le savant, croire la science achevée est toujours une illusion aussi complète que le serait pour l’historien de croire l’histoire terminée. »

Louis de Broglie

Maurice et la Physique

Maurice de Broglie est un physicien expérimental passionné. Il a installé dans l’hôtel familial un laboratoire où il mène des recherches de spectroscopie assez pointues. Un expérimentateur a besoin d’un assistant et qui d’autre que le jeune Louis pour embrasser ce rôle ?

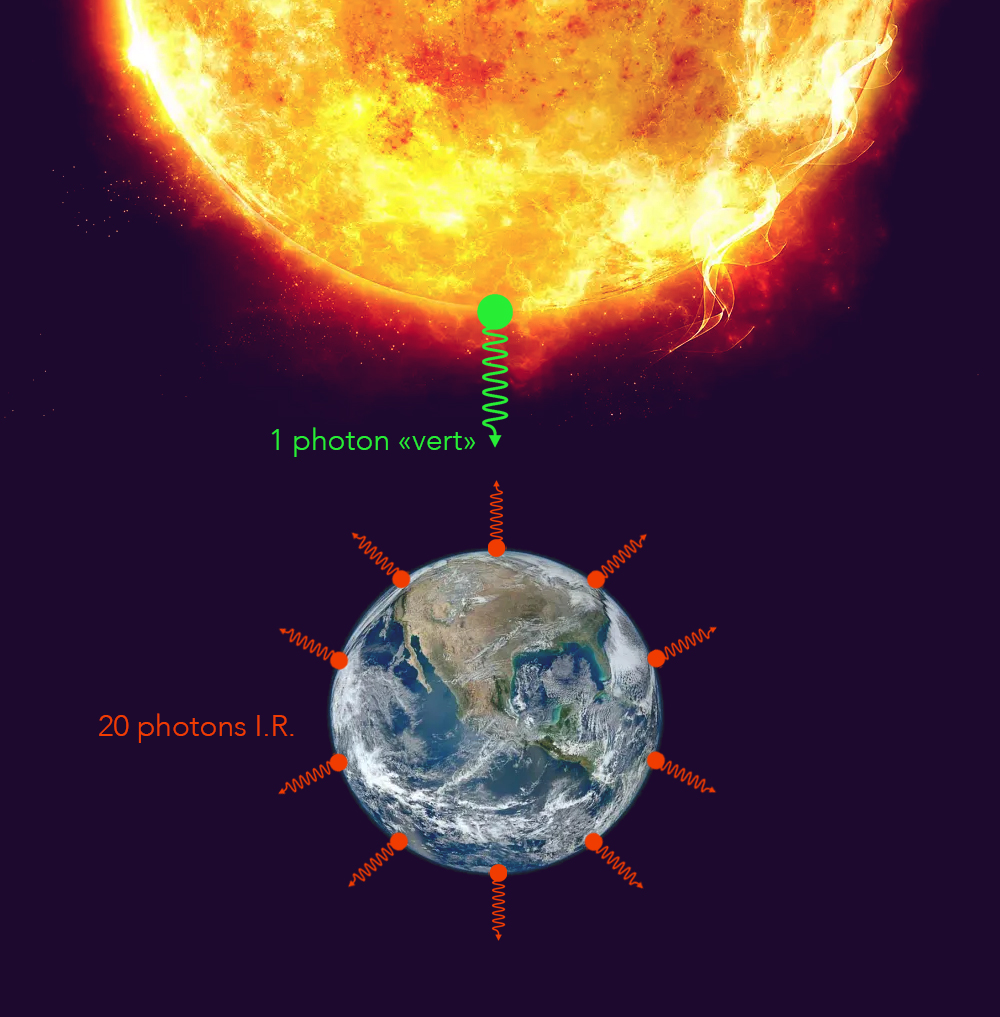

Maurice l’initiera alors aux travaux de Planck, Bohr et Einstein qui mettaient alors en évidence la dualité onde-corpuscule de la lumière.

Louis est fasciné par ces questions fondamentales. Il abandonne alors ses études d’histoire pour se consacrer à la physique. Pendant la Première Guerre mondiale, il sert aux radiotransmissions à l’émetteur de la tour Eiffel et atteint le grade d’adjudant. Après la guerre, il reprend alors ses études et propose en 1924 une thèse de doctorat qui va bouleverser tout ce que l’on pensait savoir sur la nature fondamentale de la matière.

La dualité onde-corpuscule de la matière

Son idée est finalement très simple, mais très audacieuse : si la lumière, que l’on pensait être une onde depuis Young, se comporte parfois comme un corpuscule selon les idées de Planck et d’Einstein… alors pourquoi une particule de matière, comme l’électron, que l’on pense être un corpuscule, ne pourrait-elle pas également se comporter comme une onde ?

C’est l’acte de naissance des ondes de matière.

Détail physique et mathématique

On connaît bien la relation d’Einstein :

E=mc²

qui nous dit que l’énergie est égale à la masse multipliée par le carré de la vitesse de la lumière.

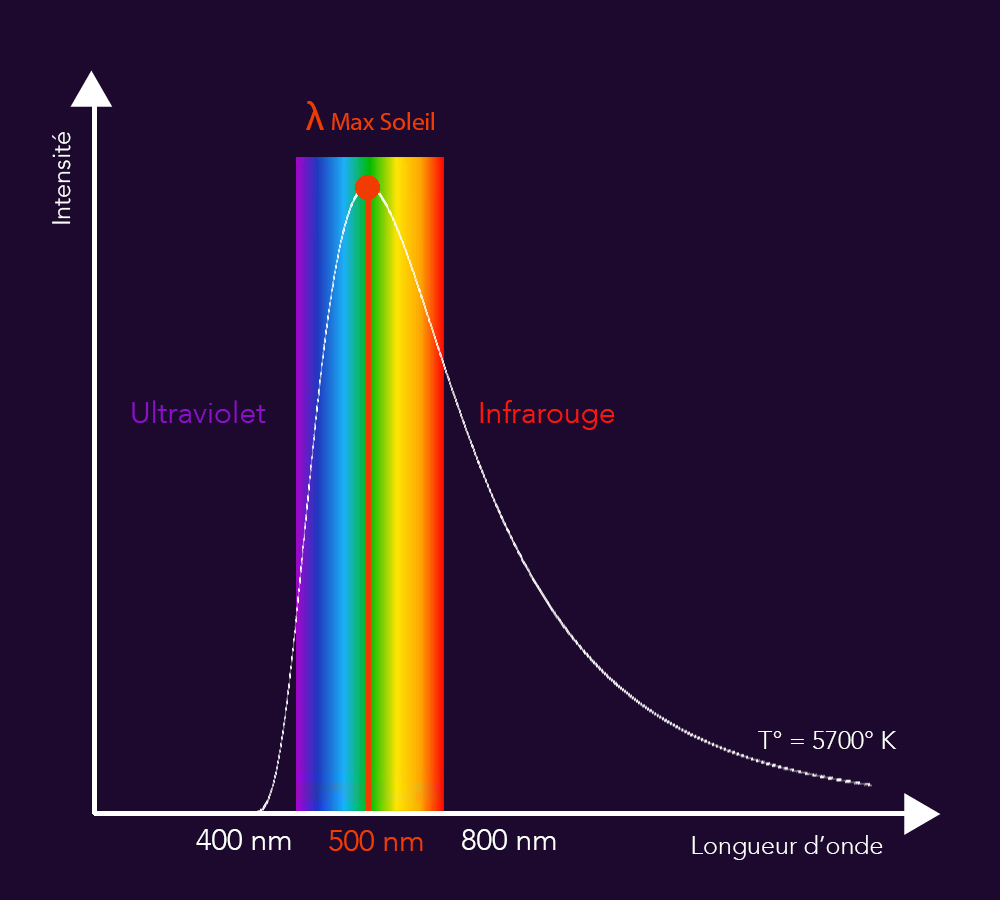

On a déjà vu aussi la relation de Planck :

E=hν

Elle lie l’énergie E d’un photon à sa fréquence v, à une constante multiplicative près : h, la constante de Planck. Cette relation montre bien l’aspect corpusculaire d’un photon car elle partitionne l’énergie d’une onde lumineuse en « petits paquets » qu’on appellera alors quantas, puis photons.

Si on s’en tient à ces deux formules de l’énergie, alors :

mc²=hv.

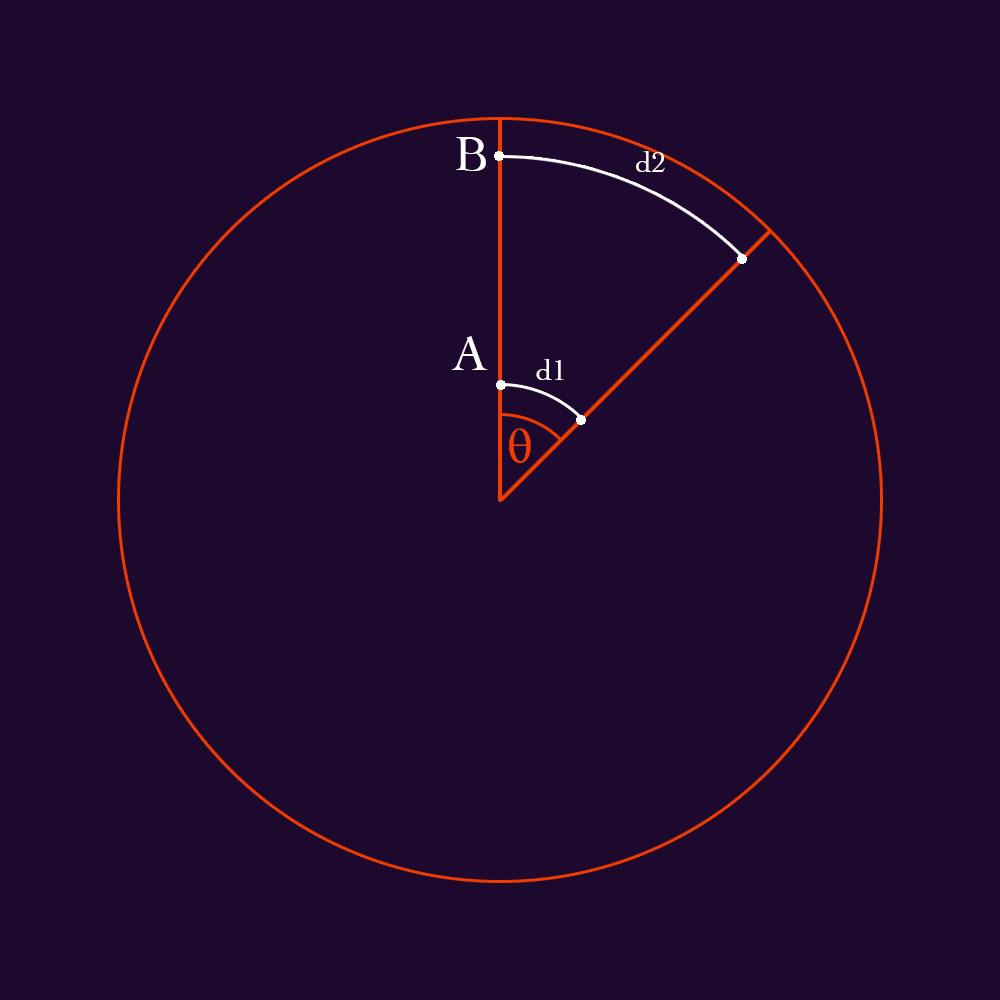

La fréquence v peut aussi s’exprimer en fonction de la longueur d’onde comme suit :

v = c/λ

Soit la vitesse de la lumière divisée par la longueur d’onde λ, ce qui nous donne, si on remplace :

mc2 = h(c/λ)

Qu’on peut simplifier par c. On obtient alors :

mc = h/λ.

Mais mc, pour un photon, c’est simplement sa masse multipliée par sa vitesse… en d’autres termes, sa quantité de mouvement, qu’on peut noter simplement p. On obtient alors

p=h/λ

ou, sous sa forme canonique :

λ=h/p

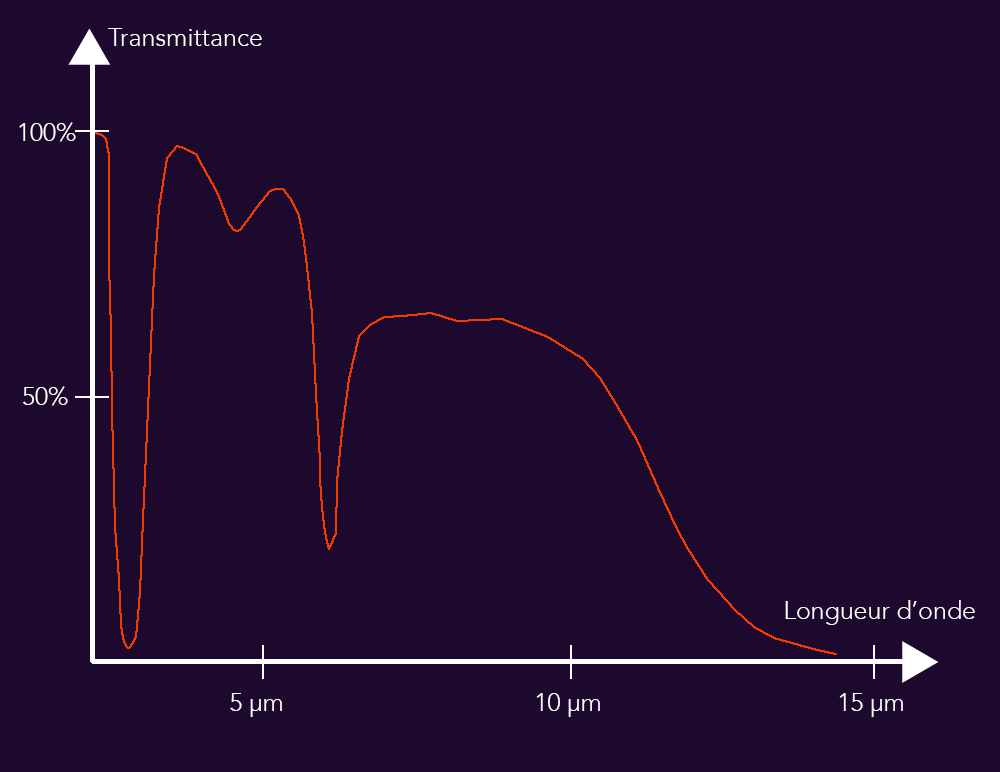

C’est là que tout se joue : De Broglie généralise ici la relation de Planck à tout corps ayant une quantité de mouvement, pour ainsi dire, tous ! la quantité de mouvement d’un électron – par exemple – se retrouve alors liée à une longueur d’onde, par une relation inversement proportionnelle, ce qui n’a de sens physique que si cet électron a une nature ondulatoire.

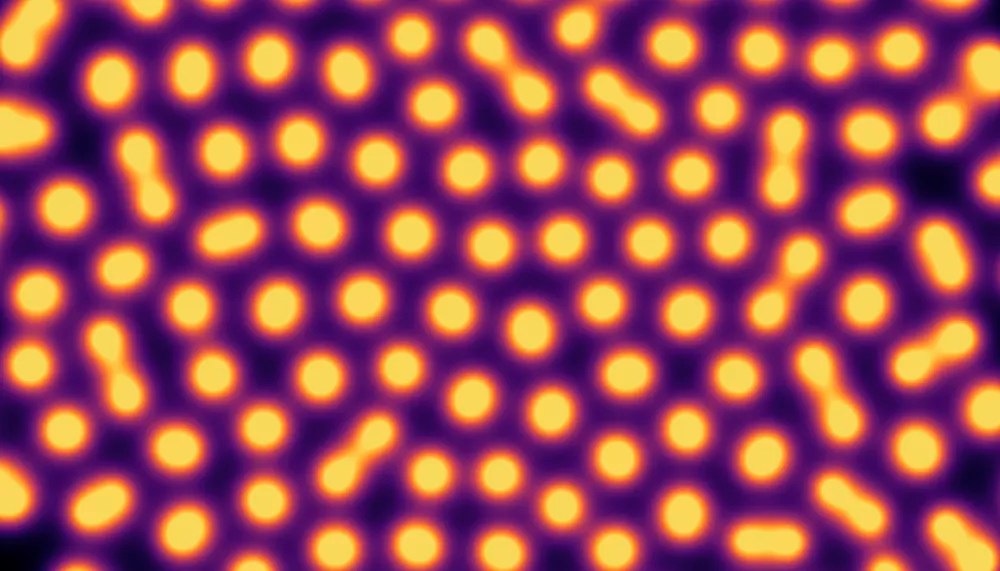

Cette idée paraît d’abord incongrue, et elle est reçue de façon mitigée. Mais en 1927, l’expérience de Davisson et Germer montre qu’un électron peut en effet produire des figures de diffraction, une propriété exclusive des ondes. La longueur d’onde qu’ils vont mesurer sera conforme aux équations de Louis de Broglie… La matière est de nature ondulatoire, et c’est une révolution qui vient bouleverser notre idée intuitive du réel.

Solvay 1927 et l’onde pilote

Après un tel succès, De Broglie ne s’arrête pas là. Il développe une théorie de l’onde pilote, une interprétation déterministe de la mécanique quantique. Dans son idée, les particules sont réelles et suivent des trajectoires bien définies, guidées par une onde qui les pilote dans l’espace.

Cette approche s’oppose radicalement à l’interprétation de Copenhague défendue par Niels Bohr et Werner Heisenberg, selon laquelle les particules n’ont pas de propriétés définies avant d’être observées.

« Le cadre de l’espace et du temps est essentiellement statique : un corps, une entité physique, qui a une localisation exacte des l’espace et dans le temps est, par le fait même, privé de toute propriété évolutive. »

Au congrès Solvay de 1927, De Broglie présente sa théorie aux plus grands physiciens de l’époque. L’accueil est glacial. Bohr et ses disciples attaquent violemment ses idées en disant qu’elles sont inutilement compliquées et rétrogrades. Wolfgang Pauli, particulièrement virulent, ridiculise la notion d’onde pilote. Face à cette opposition et à cause de son incapacité à répondre à toutes les objections techniques, De Broglie finit par abandonner sa théorie. Il se rallie à l’interprétation de Copenhague, renonçant pendant des décennies à ses idées. Cet épisode le relègue au ban des physiciens pendant une vingtaine d’années.

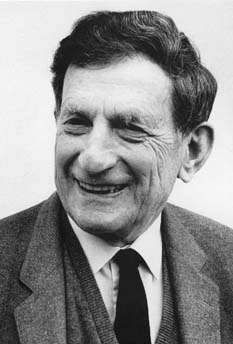

David Bohm

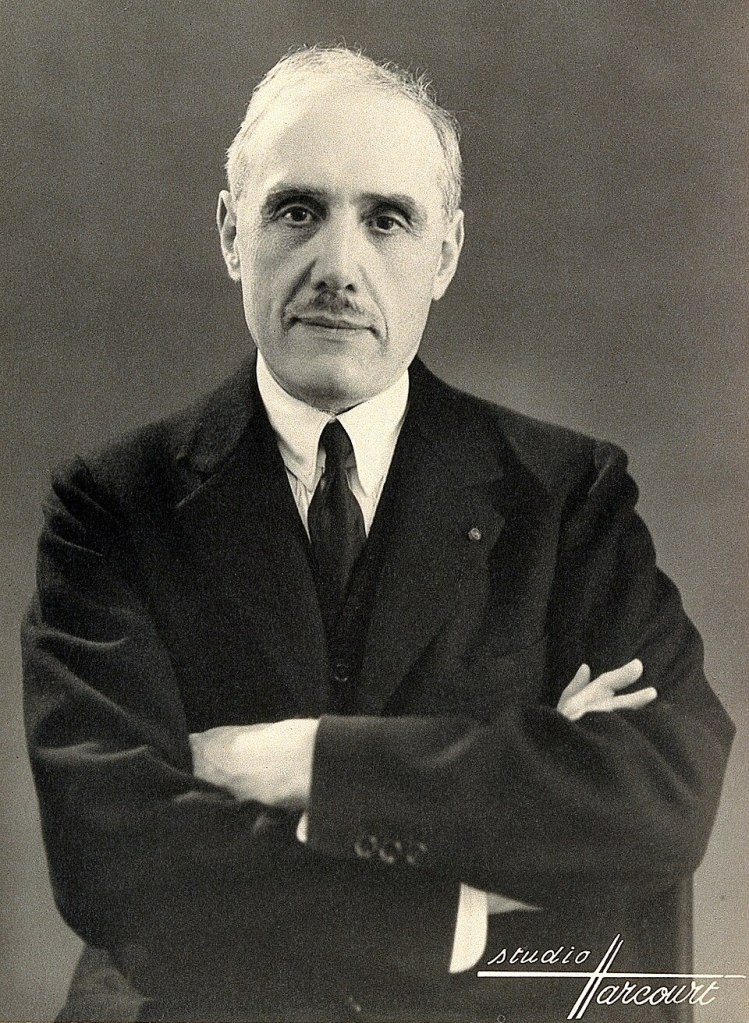

Dans les années 50, David Bohm redécouvre de façon indépendante les idées de de Broglie et les reformule de façon plus rigoureuse. C’est la naissance de la mécanique bohémienne.

Il y démontre qu’une interprétation déterministe et réaliste de la mécanique quantique est tout à fait viable philosophiquement et mathématiquement.

Les idées de Bohm poussent de Broglie à reprendre ses travaux sur l’onde pilote, qu’il va poursuivre jusqu’à la fin de sa carrière. L’interprétation réaliste de la mécanique quantique, même si elle reste marginale, va gagner le respect de ses contemporains. Lee Smolin, un des pères de la théorie de la gravitation quantique à boucles, va même y consacrer un livre dans lequel il soulignera la résolution de nombreux paradoxes permise par la théorie de l’onde pilote. Il voit même dans cette interprétation une piste solide pour la résolution d’un des plus grands défis de la physique moderne sur lequel il travaille : la gravitation quantique.

La dualité en héritage

Louis poursuit une longue carrière académique, occupant une chaire de physique théorique à la Sorbonne et devenant secrétaire perpétuel de l’Académie des sciences de 1942 jusqu’à sa mort. Il enseigne à plusieurs générations de physiciens français et publie de nombreux ouvrages de vulgarisation, cherchant à transmettre sa vision philosophique de la physique.

Mais malgré les honneurs qu’il reçoit – il est fait membre de l’Académie française en 1944 – De Broglie reste marqué par le rejet de ses idées les plus chères. Il meurt le 19 mars 1987 à Louveciennes, à l’âge de 94 ans, ayant assisté au début de la réhabilitation de sa théorie sans en voir le plein épanouissement.

Son destin illustre les difficultés de la recherche scientifique ; parfois, avoir raison trop tôt revient à avoir tort, et les idées les plus fécondes doivent attendre des décennies avant d’être reconnues à leur juste valeur. Le physicien laisse derrière lui un héritage tout en dualité : il a beau avoir révolutionné notre idée du réel, il reste le plus méconnu des grands génies de la quantique.